Kecerdasan Buatan Google Belajar Menganalisis Dunia Melalui Kamera Smartphone

Arkadiy Andrienko

Arkadiy Andrienko

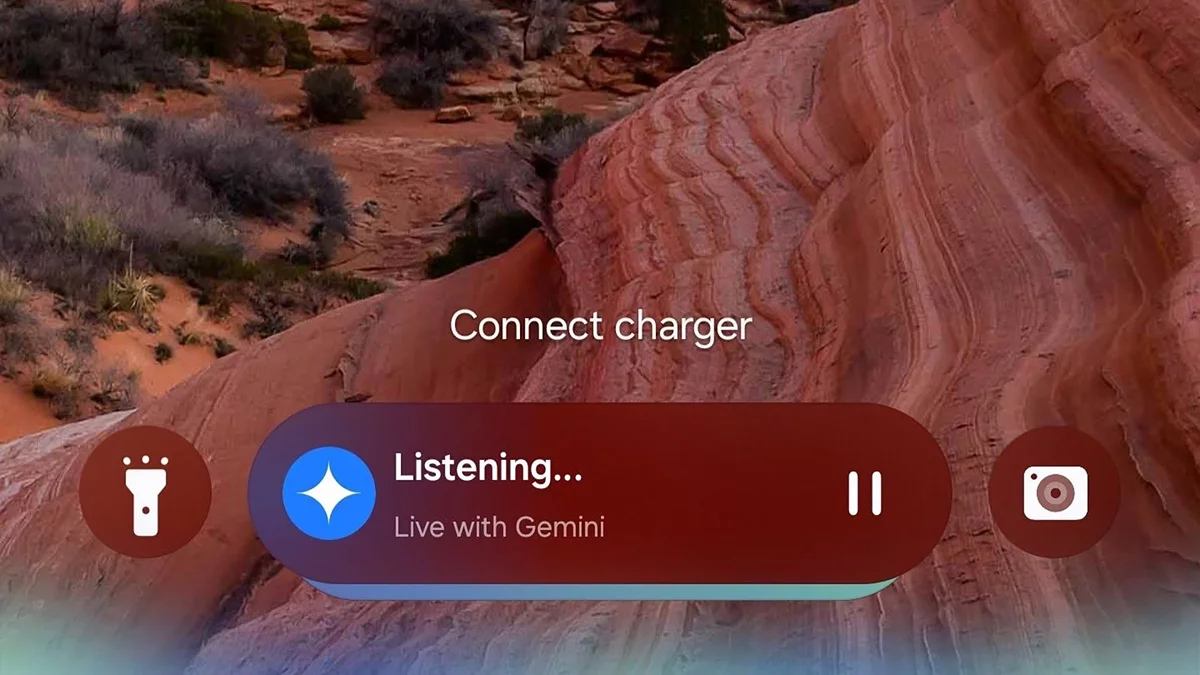

At MWC di Barcelona, Google memperkenalkan fitur-fitur baru yang revolusioner untuk asisten AI-nya, Gemini. Mulai Maret, pelanggan paket Google One AI Premium akan dapat mengubah smartphone mereka menjadi 'mata' bertenaga AI berkat dua inovasi kunci—Analisis Video Langsung dan Berbagi Layar Cerdas.

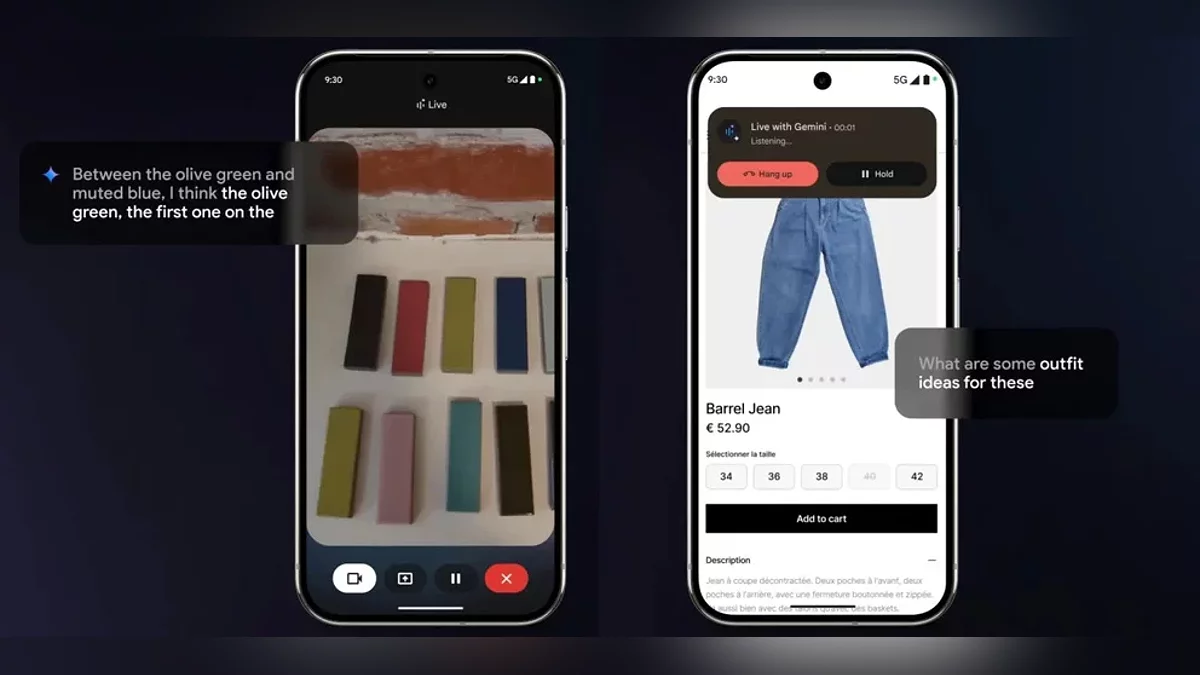

Analisis Video Langsung memungkinkan asisten untuk memproses input kamera secara real-time dengan instan. Pengguna dapat mengarahkan kamera mereka ke sepotong pakaian untuk mendapatkan saran gaya atau memindai sebuah ruangan untuk menerima saran desain interior. Gemini tidak hanya "melihat" apa yang ada di layar—ia secara aktif terlibat dalam dialog. Misalnya, pengguna dapat memintanya untuk mengoptimalkan rute navigasi atau menjelaskan grafik kompleks dalam presentasi, menerima penjelasan dalam format yang dinamis dan percakapan.

Saat ini, fitur-fitur ini hanya tersedia di perangkat Android dengan dukungan multibahasa. Di stan Google, perusahaan menampilkan Gemini yang berjalan di perangkat Samsung, Xiaomi, dan perangkat mitra lainnya, menekankan kompatibilitas lintas merek. Belum ada kabar kapan pengguna iOS akan mendapatkan akses.

Pembaruan yang diumumkan hanyalah satu langkah menuju proyek ambisius Astra milik Google. Pada tahun 2025, perusahaan bertujuan untuk mengembangkan asisten multimodal universal yang mampu:

- Menganalisis video, audio, dan data teks secara bersamaan;

- Mempertahankan konteks percakapan hingga 10 menit;

- Mengintegrasikan data dari Pencarian, Lens, dan Peta untuk solusi yang komprehensif.

Meskipun Google belum secara resmi mengumumkan Astra sebagai produk mandiri, para ahli berspekulasi bahwa fitur-fiturnya akan secara bertahap diintegrasikan ke dalam Gemini, meningkatkan persaingan dengan ChatGPT. Perlu dicatat, OpenAI telah menawarkan mode suara yang diperluas dengan analisis layar sejak Desember 2023, tetapi Google bertaruh pada integrasi mendalam dengan ekosistemnya sendiri.

Kemampuan AI untuk memproses informasi visual secara real-time semakin memudarkan batas antara dunia digital dan fisik. Pengguna tidak lagi hanya berinteraksi dengan "asisten berbicara" tetapi terlibat dengan peserta aktif dalam tugas sehari-hari mereka—dari berbelanja hingga belajar. Dengan peluncuran Gemini Vision, asisten AI memasuki era interaksi hiper-kontekstual, di mana pertanyaan kunci beralih dari "Bagaimana saya bertanya?" menjadi "Apa yang saya tunjukkan?"

Satu pertanyaan besar tetap: privasi. Bagaimana Google akan melindungi data yang ditransmisikan melalui kamera dan layar? Perusahaan meyakinkan bahwa semua analisis dilakukan di bawah standar keamanan yang ketat, tetapi rincian lengkapnya hanya akan diungkapkan setelah fitur-fitur tersebut resmi dirilis.